Sans trop de surprises, la nouvelle vague d’intelligences artificielles dite «génératives» a démontré que ces algorithmes de pointe n’échappent pas aux préjugés sexistes. Contenus hypersexualisant les femmes, reproduction de stéréotypes, ou discriminations genrées, le constat en dit long sur les limites et les problématiques de ces outils présentés comme révolutionnaires. Cependant, pour Estelle Pannatier, chargée de politique et de plaidoyer chez AlgorithmWatch CH, des recours juridiques existent déjà pour encadrer ces dérives. Toutefois, la construction et l’utilisation des IA manquent de transparence pour mettre en évidence les discriminations qu’elles provoquent.

- Le Temps: Qu’est-ce que l’on entend par biais sexistes dans le domaine de l’IA?

- Estelle Pannatier: Le terme de biais algorithmique est généralement utilisé pour décrire des erreurs systématiques dans un système informatique qui créent des résultats injustes, en privilégiant une catégorie par rapport à une autre d’une manière injustifiée. Dans ce contexte, un biais sexiste serait par exemple le fait qu’un algorithme attribue des scores de risques différents selon le genre de la personne dans un contexte où cette différence ne se justifie pas. La notion de biais est toutefois un peu réductrice. Son utilisation se limite généralement à la qualité des données des systèmes avec l’idée suivante: ce sont les données qui entraînent les biais et qui conduisent les IA à faire des distinctions basées par exemple sur le genre. Or, les inégalités de genre engendrées par l’utilisation de l’IA ont des causes diverses.

- Ces discriminations sexistes ne sont donc pas simplement le résultat des biais présents dans les bases de données utilisées?

- La qualité des données joue évidemment un rôle. La date à laquelle elles ont été récoltées, la manière dont elles ont été traitées etc, mais il y a beaucoup de choix humains qui se cachent derrière ce travail. Au-delà de la problématique des données, il y a aussi la question des modèles d’IA utilisés par ces algorithmes, c’est-à-dire les paramètres qui sont choisis, et finalement de l’utilisation de ces systèmes. Même un système technologiquement «parfait» peut avoir des conséquences discriminantes s’il est utilisé à mauvais escient.

- Concrètement, comment ces biais affectent-ils le fonctionnement des IA?

- Prenons l’exemple d’un algorithme basé sur l’apprentissage autonome conçu pour le recrutement dans une entreprise. Si historiquement dans cette société les femmes occupent moins de postes de responsabilité que les hommes, et que l’algorithme est entraîné sur ces données sans correction, il va reproduire ce déséquilibre. Au niveau des modèles, pour un algorithme qui va trier des CV par exemple, des humains vont devoir fixer des critères d’exclusion pour ceux qui ne sont pas retenus. Or, ces critères peuvent être biaisés.

- Quel effet ces biais peuvent-ils avoir sur les femmes?

- Pour les personnes concernées, les conséquences peuvent être importantes. La situation peut entraîner un accès inégal à l’emploi. Une recherche que nous avons menée a montré que sur Facebook des offres d’emploi étaient montrées à un profil en fonction du genre de l’utilisateur. Une annonce pour la conduite de camions est plutôt affichée aux hommes, celle pour la garde d’enfants plutôt aux femmes. Il y a aussi eu un exemple très médiatisé en Autriche, où le service de l’emploi a utilisé un algorithme pour évaluer les chances des personnes au chômage de retrouver un emploi. Celui-ci retirait des points aux femmes si elles avaient des personnes à charge mais n’en retirait pas aux hommes dans la même situation, ce qui pouvait ainsi les priver injustement de l’accès à certaines prestations sociales.

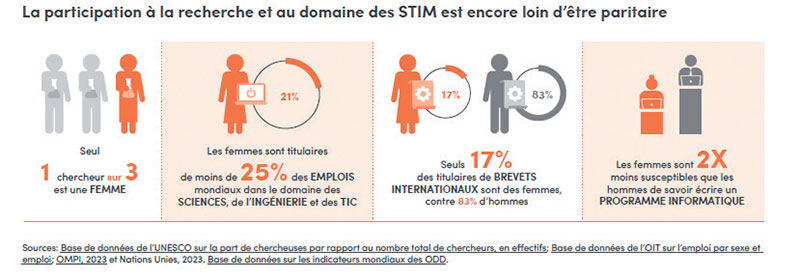

- Le manque de femmes, régulièrement pointé du doigt, dans les différents domaines des technologies, pèse-t-il également dans le développement des IA?

- Les personnes qui conçoivent ces technologies y infusent leurs idées pendant leur conception. Il y a une tendance à sous-estimer la composante humaine de ces outils. Avoir plus de diversité à la base de la conception des intelligences artificielles ne peut être que positif quel que soit le type de discrimination. Mais il faut également mettre en place des processus, comme des analyses d’impact sur les droits fondamentaux, pour veiller à ce que ces systèmes n’engendrent pas de discrimination.

- Il y a un an, on commençait tout juste à parler d’IA génératives. Dans le domaine des technologies, la législation donne souvent l’impression d’avoir un train de retard. Tout cela ne va-t-il pas trop vite pour pouvoir le réglementer efficacement?

- C’est un domaine qui évolue très vite mais il faut tout d’abord rappeler que nous ne sommes pas dans un désert juridique. Les lois et les normes actuelles s’appliquent aussi à l’IA. Diverses initiatives se mettent en place pour combler les lacunes en matière de régulation, comme le règlement sur l’IA au niveau de l’Union européenne ou la convention sur l’IA en cours de négociation au sein du Conseil de l’Europe. En Suisse, le Conseil fédéral analyse jusqu’à fin 2024 les besoins en matière de réglementation de l’IA.

- Mais comment peut-on encadrer un objet aussi mouvant pour éviter les dérives sexistes?

- Il faut tout d’abord garantir la transparence pour les personnes concernées et la société en général, en particulier lorsque ces systèmes sont utilisés pour prendre des décisions sur les personnes. La conception et l’utilisation des systèmes devraient également faire l’objet d’analyses d’impact pour identifier les risques en matière de droits fondamentaux et les mitiger. Finalement la protection contre la discrimination devrait être renforcée pour protéger contre la discrimination algorithmique, notamment en renforçant les moyens de recours des personnes concernées.

- Au-delà des discriminations, on a aussi constaté que ces outils dits «génératifs» ont été employés pour produire des deepfakes pornographiques ou des contenus hypersexualisant les femmes.

- Des moyens juridiques, notamment des outils relatifs à l’atteinte à l’honneur, peuvent s’appliquer dans certaines de ces situations. Mais il y a un travail important à accomplir autour de l’application du cadre légal: cela prend beaucoup de temps et d’énergie pour parvenir à faire retirer un contenu. Il faut aussi clarifier les responsabilités, par exemple définir quelles sont les responsabilités lorsque des contenus illégaux sont générés.

- Quelles sont les principales difficultés qui se posent aujourd’hui pour éviter les dérives de l’IA?

- Il y a une réelle difficulté à identifier les cas de discrimination liés à l’utilisation de systèmes algorithmiques, aussi bien pour les personnes concernées par les discriminations que pour les personnes qui cherchent à les dénoncer, car il faudrait souvent pouvoir «entrer dans la machine». Or les enjeux sont fondamentaux, notamment dans le cas d’algorithmes qui interviennent dans la prise de décisions et qui peuvent avoir un impact important sur la vie d’une personne, par exemple dans le contexte de la migration ou de la poursuite pénale.

Propos recueillis par Etienne MEYER-VACHERAND

Le saviez-vous?

■ Les bourses de recherche allouées aux femmes sont moins importantes que celles allouées à leurs collègues masculins et que, bien qu’elles représentent 33,3% de la population de chercheurs, les femmes n’occupent que 12% des sièges dans les académies nationales des sciences.

■ Dans les secteurs de pointe tels que l’intelligence artificielle, les chercheuses ne représentent que 22% des professionnels.

■ Malgré une pénurie de compétences dans la plupart des domaines technologiques moteurs de la 4e révolution industrielle, les femmes ne représentent que 28% des diplômés en ingénierie et 40% des diplômés en informatique.

■ Les carrières des chercheuses ont tendance à être plus courtes et moins rémunérées. Leurs travaux sont sous-représentés dans les revues de haut niveau et elles sont souvent ignorées pour des promotions.

Violence numérique, chiffres et faits

■ Définition: La violence numérique est définie comme tout acte commis ou amplifié à l’aide d’outils ou de technologies numériques causant un préjudice physique, sexuel, psychologique, social, politique ou économique aux femmes et aux filles en raison de leur sexe. La violence en ligne à l’encontre des femmes et des filles s’est rapidement intensifiée ces dernières années, menaçant gravement leur sécurité et leur bien-être. La pandémie de Covid-19 a vu ce phénomène s’aggraver, avec le plus large recours aux connexions virtuelles dans le cadre du travail, des activités scolaires et sociales. Les algorithmes et les outils liés à l’intelligence artificielle (IA) sont potentiellement en mesure de diffuser et de renforcer des stéréotypes sexistes néfastes.

L’absence d’une définition commune de la violence facilitée par la technologie contre les femmes et les filles a un impact sur le manque de données comparables au niveau mondial. Mais les données disponibles recueillies aux niveaux national et régional confirment des taux de prévalence élevés.

■ Dans l’Union européenne, une femme sur 10 a été victime de cyberharcèlement depuis l’âge de 15 ans, notamment après avoir reçu des courriels ou des SMS non désirés et/ou offensants et sexuellement explicites, ou des avances offensantes et/ou inappropriées sur des sites de réseaux sociaux.

■ Dans les Etats arabes, une étude régionale a révélé que 60 pour cent des utilisatrices d’Internet de la région avaient été exposées à la violence en ligne au cours de l’année écoulée.

■ Les Nations unies élaborent actuellement un code de conduite pour l’intégrité de l’information sur les plateformes numériques. Ce code vise à apporter une réponse mondiale concertée aux menaces pesant sur l’information, fermement ancrée dans les droits de l’homme, notamment les droits à la liberté d’expression et d’opinion et à l’accès à l’information. Le code volontaire aidera à guider les Etats membres, les plateformes numériques et d’autres groupes dans leurs efforts pour rendre l’espace numérique plus inclusif et plus sûr pour tous.

-------------------------------------------

Cette publication fait partie du programme «Vers l’égalité», dirigé par Sparknews, une alliance collaborative de 16 médias internationaux mettant en lumière les défis et les solutions pour atteindre l’égalité des sexes.